Jugando con la psicoacústica (I): memoria acústica

Uno de los campos donde más me he divertido en mis etapas de formación e investigación es, sin duda alguna, en la psicoacústica. Debido a mi naturaleza basada en el entendimiento y en el intentar descomponer el porqué de las cosas, siempre que iba a un concierto y este sonaba mal me resistía a pensar que era por culpa del técnico. A veces, cuando tenía la suerte de conocerlo, sabía de antemano que era casi imposible que esa persona hiciera mal su trabajo, pero había algo en su mezcla que hacía que prefiriera irme a casa en vez de disfrutar del concierto. ¿Cómo podía ser? Lo fácil (y habitual) es dirimir la discusión a la mala praxis del técnico del momento, pero empecé a preguntarme que quizá era yo quien escuchaba mal las cosas. En definitivas cuentas, el resto del público seguía disfrutando del concierto y no parecía estar enojado por esa misma mezcla que a mi me parecía casi horrorosa. ¿Estaría sordo? ¿Qué estaba pasando?

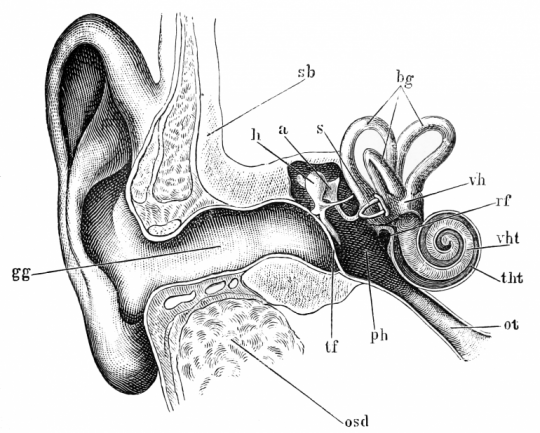

Empiezo esta serie de artículos que se alejan de las vicisitudes técnicas y nos acercan a la imperfección del ser humano. Basados en los conceptos básicos de la psicoacústica, nos ayudarán a resolver algunos de los problemas más habituales a los que nos encontramos en nuestro trabajo y que no hemos sido capaces de resolver. A todo ello, sigo esperando respuesta a uno de los dilemas que publiqué hace ya algunas semanas: ¿cómo es que el ser humano, con sólo dos orejas, es capaz de reconocer si un sonido viene del frente o de detrás?

Escucha más nuestro cerebro que nuestros oídos

Los más veteranos sin duda reconocerán esta habitual anécdota. ¿Os acordáis cuando los teléfonos eran analógicos, a pulsos, y no tenían pantallita alguna? Nos llamaban a casa y el que más cerca estaba del aparato lo recogía con un “dígame” universal. Luego, nuestro cerebro empezaba su catarsis: a partir del “hola” siguiente debía resolver a velocidad de vértigo quién se encontraba al otro lado del aparato. En ambientes familiares nadie se presentaba, como dando por hecho que todo el mundo se reconoce, pero no es así.

Los teléfonos analógicos (e incluso los digitales de hoy en día) utilizan un método de compresión de datos muy eficiente: reducen el ancho de banda en la respuesta de frecuencia para así enviar menos datos. La voz tiene su dominante en frecuencia entre los 2 y 6 kHz, por lo que todo lo que está por debajo y encima es futil si lo que queremos es centrarnos en el mensaje. Bueno, lo es menos para un dato: son esos armónicos superiores e inferiores los que determinan el timbre de cada uno de nosotros. Pero el teléfono los elimina, los dilapida. Así, cuando nos llamaban y el interlocutor nos descubría empezaba a preguntarnos cómo estábamos, si estaban papá o mamá y que se pusieran al interfono… ¡Qué rabia! El del otro lado sabía quien era, pero yo era incapaz de saberlo. Pero de pronto lo reconocías: ¡era el tío José! Y en ese momento, esa voz distante, capada y fuera de lugar, parecía verdaderamente como si fuera emitida por alguien que realmente estaba a tu lado, hablándote a dos centímetros de tu cabeza. Bienvenida psicoacústica.

En el momento exacto que nuestro cerebro sabe determinar a quién pertenece esa voz, recurre a los recuerdos almacenados para reconstruir todo aquello que no nos llega. A tiempo real, añade todos esos matices que ni tan siquiera el teléfono es capaz de ofrecer, porque los ha eliminado, ofreciéndonos esa sensación de que, realmente, nuestro interlocutor está a nuestro lado.

Bose, entre otras cosas, fue reconocida por su serie de altavoces Acoustimass. Se basaban en este mismo principio. Fue capaz de ofrecer un sonido contundente y ‘espectacular’ utilizando unos minicubos y un pequeño subwoofer. ¡Sonaba de escándalo! De hecho, las primeras demostraciones de estos sistemas se hacían con trampa: permitían a los espectadores escuchar una pareja de altavoces de tipo columna, de algo más de metro de altura; y cuando estaban convencidos de la calidad de ese equipo, alguien sacaba de dentro de esa caja inherte esos dos minicubos pequeños y dejaba asombrados a los asistentes. Yo compré una pareja de ellos. Los tuve en mi casa durante unos pocos meses: sonaban bien, pero me fatigaban. Bose no inventó la capacidad de un altavoz de baja pulgada para reproducir perfectamente todas las frecuencias del espectro sonoro, sino que jugó hábilmente con nuevas ecualizaciones muy drásticas y otros elementos para conseguir una sensación de respuesta absoluta, pero que dejaba en manos del cerebro la necesidad de reconstruir todos esos sonidos que eran imposibles de reproducir físicamente. Así, tras un largo rato de escucha mi cabeza casi explotaba, cansada de estar recalculando frecuencias y generando a partir de recuerdos sonidos no emitidos. Lo mismo ocurre con los MP3.

A ver con qué pruebas el equipo de sonido

Linn Products es un pequeño, extraño pero prestigioso fabricante de productos de alta fidelidad. Los conocí hará una decena de años y me sorprendieron cuando los visitaba para realizar audiciones de sus equipos de música: nunca me permitieron utilizar mis propios CDs. Con el tiempo no sólo les doy la razón, sino que ahora entiendo el porqué. Estaban tan orgullosos de sus equipos que podían permitirse este arriesgado experimento.

Basándose en la anterior premisa, sabían que nuestro cerebro sería capaz de reconstruir infinidad de detalles sonoros incluso si las cajas no lo reproducían. Así las cosas, te incitaban a escuchar sus equipos con músicas que no conocieras, justamente, para evitar que lo que no escuchabas fuera reconstruido por tu cerebro. Cuando pruebas un equipo de sonido con una música que conoces de sobra es probable (por no decir seguro) que tu cerebro te engañe, pues además tenemos poco control sobre él. Te hará escuchar graves profundos y controlados donde no hay más que rebomborio acústico o, incluso, añadir colas de reverb donde no las hay. Si en cambio pruebas un equipo con un pasaje musical que no conozcas demasiado estarás obligado a escuchar lo que escuchas: tu cerebro no sabrá si ahí hay una línea de bajo definida, un detalle en agudos a apreciar o si existe inteligibilidad de la palabra. Si escuchas una canción en tu idioma materno es fácil que “reconozcas” palabras enunciadas donde hay barullo; en cambio, si reduces la escucha a un idioma que conozcas pero no sea tu habitual, el simple hecho de reconocer fácilmente palabras hará que estés de acuerdo con la reproducción, justamente, del espectro más crítico para el ser humano y la palabra: entre 2 y 6 kHz.

Aún así, la memoria auditiva o acústica es muy volátil si no está fijada en el recuerdo. El perfil de la voz del tío José permanecerá casi intacto de por vida, pero un ajuste determinado de un compresor para un bombo que nos suene bien puede volatilizarse en cuestión de un par de segundos, mucho antes de poder ajustar de nuevo el compresor. Por ello, muchos fabricantes de software incluyen la opción A-B que nos permite hacer esta comparación rápidamente. Y tenemos que hacerlo ipso-facto: esperar apenas 1 segundo entre dos sonidos a comparar nos inducirá totalmente al engaño.

Antes de terminar este artículo, el primero de una serie (si me lo permitís), recordar otra anécdota tremendamente común: el músico que pide que le subas un poco la guitarra y que de pronto te felicita por ello cuando tu ni siquiera has tocado potenciómetro alguno. Lo mismo nos ocurre a nosotros (como técnicos): la cantidad de ajustes que realizamos al vuelo durante una actuación que no ejercen función alguna pero que, engañados por nuestro cerebro, creemos que son factibles. Para solucionar esto saquemos provecho de lo que hemos dicho justo ahora: si nuestra memoria acústica es volátil al segundo, entre un cambio y la comparación del siguiente hagamos un mini-reset de nuestra percepción sonora. ¿Cómo? Escuchamos el bombo, lo modificamos y acto seguido centramos nuestra atención en la caja… para luego volver a escuchar el bombo, esta vez limpio de recuerdos, para oir lo que realmente suena.

Con más de 20 años de experiencia en los escenarios, es técnico de sonido especializado en FOH. Trabaja para bandas nacionales e internacionales como técnico de mesa, y es productor técnico para diferentes festivales y grandes eventos. Kinosonik es su estudio de sonido basado en plataforma digital. Le gusta compartir y le encanta aprender.