Holaa!!

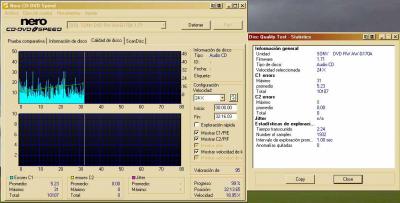

Oí varias veces y por varias fuentes que al incrementar la velocidad, los programas empezaban a reducir datos y a interpolar. Incluso me dijeron que por aquí en Bilbao, había un freaky que era capaz de diferenciar un cd audio grabado con easy cd creator y Nero. Así que empecé a hacer pruebas, audiciones y gráficos para ver que había de verdad en eso.

Si le pides más velocidad de grabación al programa, parecía lógico pensar que por ejemplo, cogiera solo un tanto por ciento de los datos, e interpolara. No a nivel espectral, reduciendo tales frecuencias ( el ejemplo del mp3 no ha sido el mejor, desde luego...

perdón) , sino aplicando logarítmos de interpolación en el dominio de amplitud/tiempo.

Me explico, aunque creo que ahora ya me estoy explicando mejor y Fourier ya me ha entendido.

Si tengo una muestra ( en el segundo 01:00:00, por ejemplo) con un valor de amplitud ( voltage ) "y", y tres samples ( muestras) más adelante tengo otra con el mismo valor "y", se puede interpolar y decir que las muestras intermedias también tienen una amplitud "y".

Pero en realidad puede que hayan oscilado, y una era "y+1" y la otra "y+2", con lo que en lugar del diente de sierra original, con la interpolación nos queda una linea recta.

Origen...............................interpolando

Muestra 1= y..............................y

Muestra 2= y+1...........................y

Muestra 3= y+2...........................y

muestra 4= y..............................y

Esta posibilidad me pareció muy peligrosa, así que intenté sacar algunas conclusiones. Mis análisis y mis preocupaciones iban en este sentido. Buscaba ver si se aplican procesos haciendo una especie de down-sample-rate. Algo parecido a reducir la frecuencia de muestreo, sospechando que tal vez al incrementar la velocidad el sistema de codificación empezaba a fallar, o a no ser tan riguroso, y empezaba a rellenar con "paja" suponiendo cosas raras....

Los datos que se graban en un cd, corrígeme porque no es precisamente mi campo, no dejan de ser los valores de las muestras, o sea, un valor de amplitud en un determinado momento o sample. El CD podrá ir por bloques o por códigos en los cuales, sinceramente me pierdo, pero no creo que se pueda decir que:

fourier escribió:

pero un CD son solo bloques de hendiduras ( lands y pits ) no tiene ninguna relacion con la forma de onda

fourier escribió:

a que es tan complejo el sistema del CD que la señal que en el se almacena no tiene absolutamente ninguna correlacion directa con la forma de onda de la señal cuantificada

Entiendo que el cd tiene sus códigos y sus formas, pero lo que registre, tras varios algorítmos, son los registros de amplitud de cada sample. Puede que los desparrame como dices:

fourier escribió:

el proceso de scramble ( aleatorizacion de los bits ) trata de desperdigar los bits a lo largo de los bloques con el fin de que un error de rafaga, por ejemplo un rallajo no afecta a un trozo de una cancion.

Puede usar no sé que tipo de métodos, ni en qué idioma, pero lo que quede registrado será música, o algo, que tras decodificarlo, volverá a ser música. Y mi mini-estudio, iba encaminado a ver si lo que mando entrar en un cd es lo mismo que recibo al reproducirlo después de tanto desparrame y despiporre de datos.

Insisto:

No pretendía ver los errores, ni los clicks....etc. Pretendía ver si al subir la velocidad, el programa empieza a no ser tan exhaustivo ni tan preciso, no por errores accidentales, sino por errores provocados por los programadores ante la necesidad de subir de velocidad y verse con poco ancho en el buss, o poco buffer o poco micro, y antes de que se quede colgado el sistema, hayan preferido sacrificar la calidad de audio reduciendo el número de muestras originales que se registren en el CD por suposiciones interpoláricas.

Hay que recordar que cuando se germinaron los programas de tostado, los ordenadores no eran lo que son ahora, y había que ahorrar recursos de donde fuera.

Así que si, entiendo que estamos hablando de dos cosas diferentes, y es que, no me había expresado tan bien como me lo había imaginado en mi cabeza

Un saludo!!!